Cùng xem Kỹ thuật Dropout (Bỏ học) trong Deep Learning trên youtube.

- Sau này chúng ta cái gì cũng có, nhưng lại không có chúng ta – Tuổi Trẻ Online

- Trường trung cấp trong tiếng Anh: Định nghĩa, ví dụ

- Hệ thống tài khoản – 331. Phải trả cho người bán

- Windows 10 Pro N là gì, win 10 Pro và win 10 Pro N khác gì nhau

- Xét tuyển nguyện vọng là gì? Những lưu ý khi đăng ký xét tuyển nguyện vọng

1.1. bỏ học trong mạng nơ-ron là gì

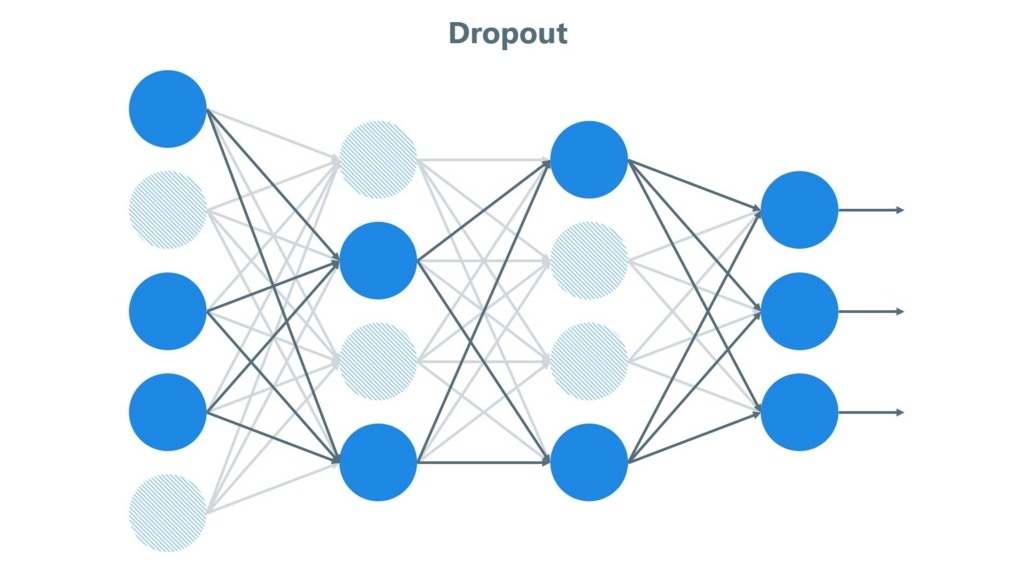

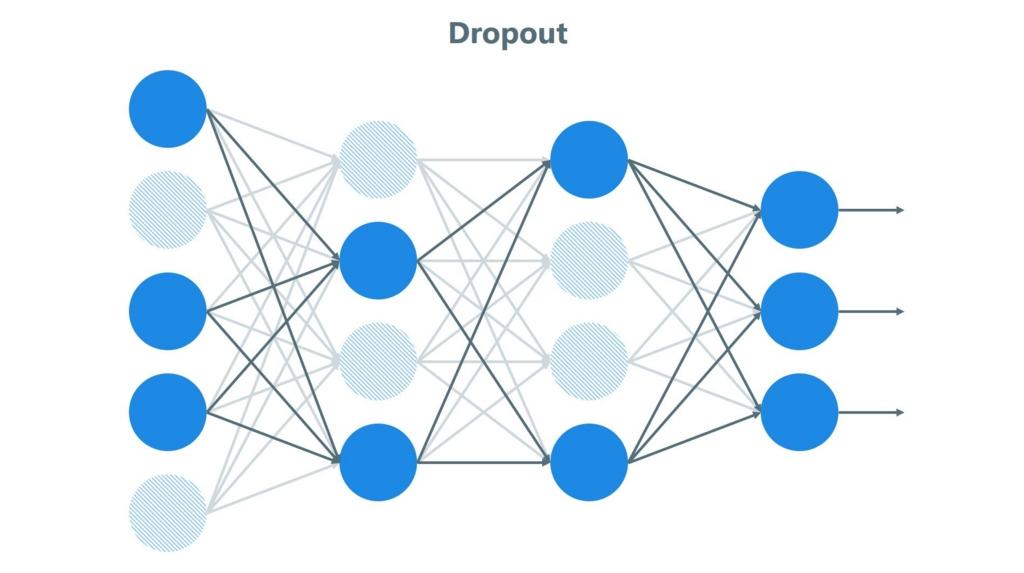

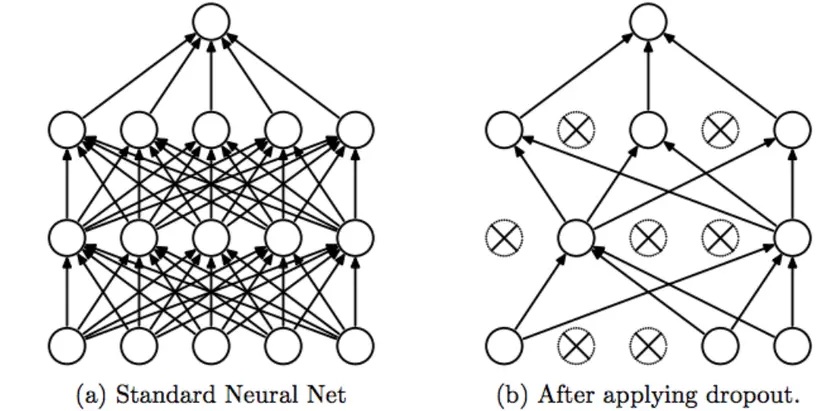

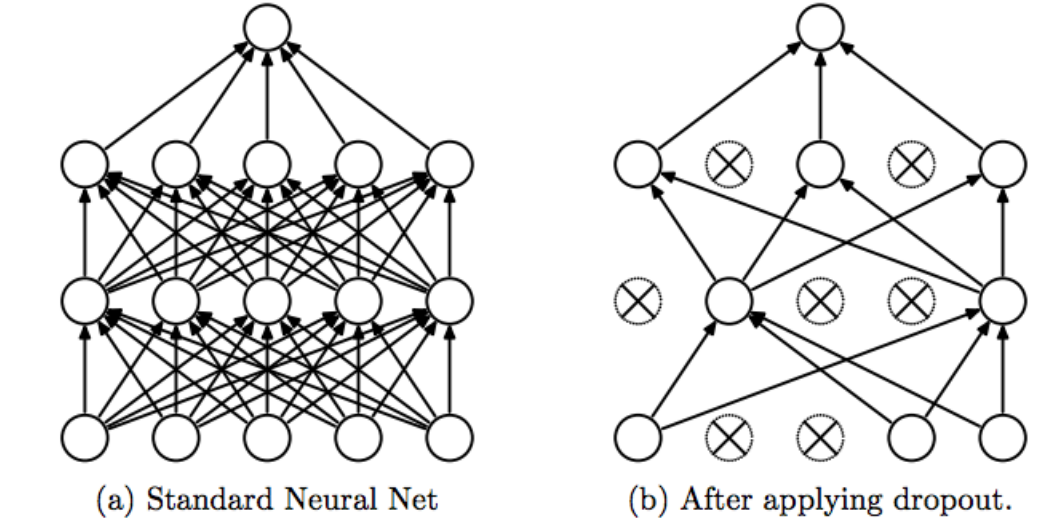

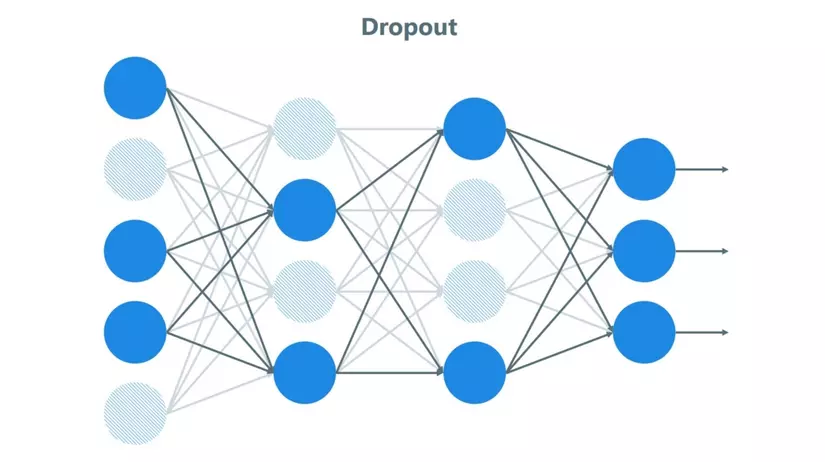

theo wikipedia, thuật ngữ ‘bỏ qua’ đề cập đến việc bỏ qua các đơn vị ẩn và hiển thị trong mạng nơ-ron.

Nói một cách dễ hiểu, bỏ học là việc bỏ sót các đơn vị (tức là 1 nút mạng) trong quá trình đào tạo ngẫu nhiên. bằng cách bỏ qua điều này, biến tần sẽ không được xem xét trong quá trình tiến và lùi. do đó, p được gọi là xác suất giữ lại 1 nút trong mỗi giai đoạn huấn luyện, do đó xác suất nó bị loại bỏ là (1 – p).

1.2. tại sao lại bỏ

Câu hỏi đặt ra là: tại sao lại đóng một số nút trong quá trình đào tạo theo đúng nghĩa đen? câu trả lời là: tránh trang bị quá nhiều

nếu một lớp được kết nối đầy đủ có quá nhiều tham số và chiếm hầu hết các tham số, các nút trong lớp đó quá phụ thuộc vào nhau trong quá trình huấn luyện, điều này sẽ hạn chế sức mạnh của mỗi nút, dẫn đến quá phù hợp.

1.3. các kỹ thuật khác

Muốn biết bỏ học là gì thì chỉ cần 2 phần lý thuyết trên là đủ. Trong phần này, tôi cũng giới thiệu một số kỹ thuật có tác dụng tương tự như bỏ học.

Trong học máy, chính quy hóa làm giảm việc trang bị quá mức bằng cách thêm một loạt các giá trị “phạt” vào hàm mất mát. bằng cách thêm 1 trong các giá trị đó, mô hình của bạn sẽ không học được quá nhiều sự phụ thuộc giữa các trọng số. Tôi chắc rằng nhiều người quen thuộc với hồi quy logistic đều biết rằng l1 (Laplacian) và l2 (Gaussian) là hai kỹ thuật ‘phạt đền’.

-

quy trình đào tạo: đối với mỗi lớp ẩn, mỗi trường hợp, mỗi chu kỳ, chúng tôi sẽ bỏ rơi ngẫu nhiên với xác suất (1 – p) cho mỗi nút.

Xem Thêm : Sống ảo trong tiếng Anh: Định nghĩa, ví dụ

quy trình kiểm tra: sử dụng tất cả các kích hoạt, nhưng sẽ giảm hệ số p đi 1 (để tính cho các kích hoạt bị loại bỏ).

1.4. một số nhận xét

- người bỏ học sẽ học được các tính năng hữu ích và mạnh mẽ

- gần như tăng gấp đôi số kỷ nguyên cần thiết để hội tụ. tuy nhiên, thời gian trên mỗi kỷ nguyên ít hơn.

- chúng tôi có h đơn vị ẩn, với xác suất bỏ cuộc cho mỗi (1 – p), chúng tôi có thể có 2 ^ h mô hình hình ảnh. nhưng trong giai đoạn thử nghiệm, tất cả các nút trong mạng phải được xem xét và mỗi lần kích hoạt sẽ giảm đi 1 hệ số p.

Nó hơi khó hiểu, vì vậy tôi sẽ viết mã 2 phần để xem người bỏ học trông như thế nào.

Vấn đề: Bạn đang đi xem một trận đấu bóng đá và bạn đang muốn đoán xem thủ môn sẽ sút bóng vào đâu, cầu thủ đội nhà sút bóng trúng đích.

Tôi nhập các thư viện cần thiết

hình dung dữ liệu một chút

Ta được kết quả

dấu chấm màu đỏ là một cầu thủ địa phương đã đánh đầu, chấm màu xanh lá cây là một cầu thủ đã đánh đầu. Công việc của chúng ta là dự đoán vị trí mà thủ môn sẽ ném bóng để cầu thủ địa phương có thể đánh đầu. có vẻ như bạn chỉ cần vẽ một đường để phân chia 2 khu vực.

2.1. mô hình không có chính quy

chức năng dự đoán

xem kết quả

Xem Thêm : Văn bản là gì? Chức năng, phân loại và nội dung của văn bản?

Có thể thấy độ chính xác ở tập training là 94% và tập test là 91% (khá cao). Ta sẽ visualize 1 chút

khi không có quy định, chúng tôi thấy rằng đường phân chia được vẽ rất chi tiết, có nghĩa là nó được trang bị quá mức.

2.2. mô hình chính quy hóa với sự từ bỏ

2.2.1. nhân giống chuyển tiếp

2.2.2. nhân giống ngược

sau khi chúng tôi chuyển tiếp và quay lại, chúng tôi thay thế hai hàm này trong hàm mô hình từ phần trước:

kết quả:

Chúng tôi thấy rằng, độ chính xác của bộ kiểm tra lên đến 95%, mặc dù bộ đào tạo đã bị giảm. thực hiện hiển thị:

Ta được

chúng tôi thấy rằng đường phân chia không quá chi tiết, vì vậy bạn nên tránh trang bị quá nhiều.

2.3. chú ý

- không sử dụng tính năng bỏ qua cho các thử nghiệm

- áp dụng tính năng bỏ qua cho các quy trình tiến và lùi

- giá trị kích hoạt phải giảm 1 hệ số keep_prob, được tính ngay cả đối với các nút thoát.

phương tiện

Nguồn: https://dongnaiart.edu.vn

Danh mục: FAQLời kết: Trên đây là bài viết Kỹ thuật Dropout (Bỏ học) trong Deep Learning. Hy vọng với bài viết này bạn có thể giúp ích cho bạn trong cuộc sống, hãy cùng đọc và theo dõi những bài viết hay của chúng tôi hàng ngày trên website: Dongnaiart.edu.vn